概要

前回はAIバブル論がなぜ始まったのかについて解説しました。しかし、今回取り上げるのは初めてのバブル論ではありません。実は、AIはこれまで何度もブームと冬を繰り返し、現在に至っています。まず、本当にバブルかどうかを議論する前に、過去のブームがなぜ起こったのか、そして現在との共通点や相違点を分析し、今後の展望を考察してみたいと思います。

- AIバブル論の始まり

- 過去のAI冬の時代

- 過去の冬の時代との共通点と相違点

- では、何をすべきか

2. 過去のAI冬の時代

第一のAIブーム

AIのブームや冬の期間については文献によって異なることがありますが、一般的には第一のAIブームの始まりは1950年代から1960年代とされています。特に、1956年のダートマス会議がAI研究の出発点とされています。この会議では、AIの基本的な概念や目標が定義され、多くの研究者がこの分野に参入しました。特に以下のようなテーマが議論されました。

- 機械学習:機械がどのようにして学習し、知識を獲得するかについての研究

- 自然言語処理:機械が人間の言語を理解し、生成する方法の探求

- ニューラルネットワーク:人間の脳を模倣したネットワークモデルの設計

- 問題解決のアルゴリズム:機械が複雑な問題を解決するための手法

- 抽象化と概念形成:機械が抽象的な概念を形成し、それを利用する方法

非常に高い期待値

ダートマス会議に参加した研究者たちは、AIの可能性に非常に大きな期待を寄せていました。彼らは、機械が人間の知能を模倣し、さらには超えることができると信じていました。具体的には、

- 知能の再現:機械が人間のように考え、学習し、問題を解決できるようになること。

- 自律的なシステム:機械が自律的に行動し、自己改善する能力を持つこと。

- 広範な応用:AIが医療、教育、産業などさまざまな分野で活用されること。

この会議は、AI研究の基礎を築き、その後の研究方向性を決定づける重要な役割を果たしました。参加者たちは、AIが将来の社会に与える影響についても活発に議論し、そのビジョンは現在のAI技術の発展に大きな影響を与えています。

1970年代には、エキスパートシステムと呼ばれる知識ベースのシステムが開発され、商業的な成功を収めました。これにより、AIへの関心と投資が急増しました。具体的にAIへの投資金額は文書化されていることはありませんが、米国のDARPA(The Defense Advanced Research Project Agency)がかなりの金額を投資したといわれています。

AIの冬

しかし、AIの期待が高まる一方で、技術的な限界や実用化の難しさが露呈し、1980年代から1990年代にかけて「AIの冬」と呼ばれる時期が訪れました。当初の目標や成果には到達せず、期待を大きく下回る結果しか得られなかったため、次第に期待値が低下し、それが投資額にも影響を及ぼしました。この期間中、AI研究への資金提供が減少し、多くのプロジェクトが中止されました。

第二のAIブーム(2010年〜現在)

AIの冬の時期には、特にニューラルネットワーク技術は「全く使えないもの」と見なされていましたが、それでも研究を続けた研究者がいました。特に、Geoffrey Hinton氏がその一人です。この研究の成果は、2012年のImageNetコンペティションで世界を驚かせました。 当時のエラー率は26.2%でしたが、Geoffrey Hinton氏のチームが開発したAlexNetは、その半分の15.3%というエラー率を達成しました。特に驚くべき点は、従来は人が手作業でモデルを精緻化していたのに対し、AlexNetは自ら学習することができるモデルだったことです。

ImageNetコンペティションとは

ImageNetは、視覚オブジェクト認識ソフトウェアの研究に使用されるために設計された大規模な画像データベースです。ImageNetプロジェクトでは、1,400万枚以上の画像に手作業でアノテーションを行い、画像に写っている物体を示しています。また、100万枚以上の画像にはバウンディングボックスも付与されています。

ImageNetのデータベースには、20,000を超えるカテゴリがあり、「気球」や「イチゴ」といった一般的な物体カテゴリも含まれています。2010年から2017年まで、ImageNetプロジェクトは毎年、大規模な画像認識技術コンテストであるILSVRC(ImageNet Large Scale Visual Recognition Challenge)を開催していました。このコンテストでは、ソフトウェアが物体や情景をどれだけ正しく分類、検出できるかを競います。

ドライバーは?

第二のAIブームは、主にデータ量の増加と計算能力の向上によって可能になりました。

データ量の増加

2000年代後半から、インターネットの普及とデジタル化の進展により、膨大な量のデータが生成されるようになりました。このデータは、AIモデルの学習に不可欠なリソースとなりました。例えば、2010年には世界のデータ量が約2ゼタバイト(1ゼタバイトは1兆ギガバイト)でしたが、2020年には約59ゼタバイトに達しました。

計算能力の向上

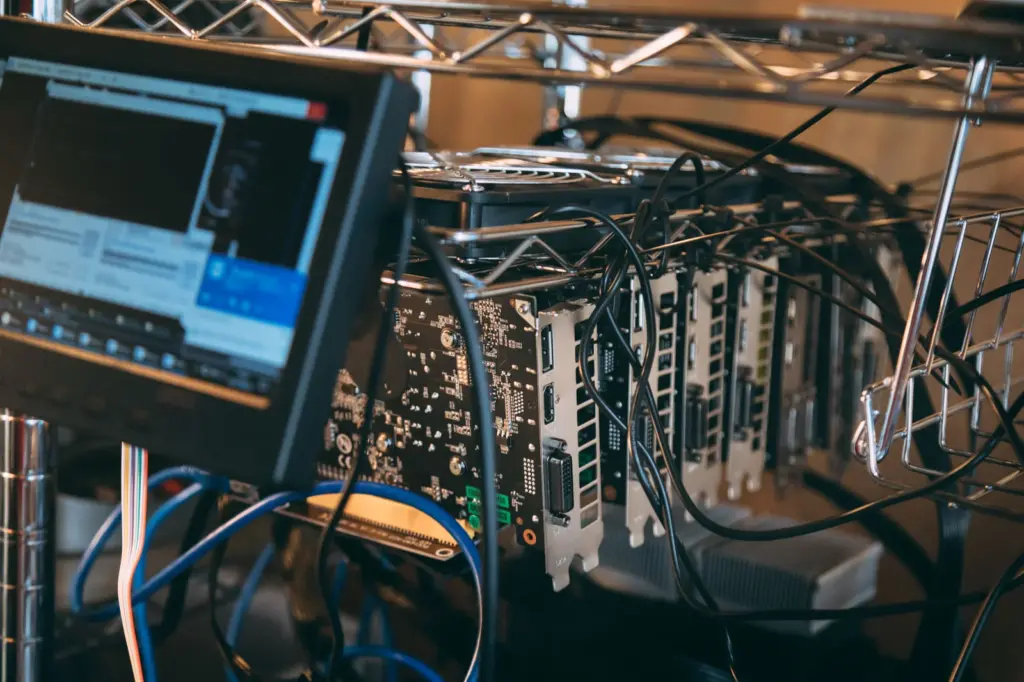

AIモデルのトレーニングには膨大な計算能力が必要です。2000年代後半から、特にGPU(グラフィックス処理装置)の進化がAI研究に大きな影響を与えました。NVIDIAのような企業が開発した高性能GPUは、AIモデルのトレーニングを飛躍的に加速させました。例えば、2012年のAlexNetは、NVIDIAのGPUを使用してトレーニングされ、その結果、従来のモデルよりもはるかに高い精度を達成しました。 さらに、計算能力の向上は指数関数的に進んでいます。OpenAIの調査によれば、AIモデルのトレーニングに必要な計算能力は、2012年から2018年の間に3.4ヶ月ごとに2倍になっていました。この急速な進化により、より複雑で高度なAIモデルの開発が可能になりました。

Reference

- AI winter – Wikipedia

- What Is AI Winter? | Built In

- AI boom – Wikipedia

- What is the ‘AI winter’ and how did it affect AI research?

- AI Winter: The Highs and Lows of Artificial Intelligence

- 2023: the year of the AI boom | The Week

- ImageNet – Wikipedia

- ダートマス会議 – Wikipedia

- ダートマス会議と人工知能の黎明期|AI-frontline

- AI研究の原点、「ダートマス会議」を解説 – ビジネス+IT

- 【AIの歴史】ダートマス会議:AI研究の歴史的マイルストーンと …

- ダートマス会議 – 【AI・機械学習用語集】 – zero to one

ピンバック: 日本の株式市場における大暴落とAIバブル論 3 – Singularity Partners

ピンバック: 日本の株式市場における大暴落とAIバブル論 4 – Singularity Partners

コメントは受け付けていません。